摘要:MySQL如期推出8.0.21版本,这里是 release notes。可能不少人在调侃MySQL为了ZZ正确,修改了诸如master/slave/whitelist/blacklist等专有名词,白做思想真是害死人。所幸这些改动在当前并没太大影响,旧的名词还能继续用一阵子。除此外,还有下面几个我认为也很重要的新功能或者性能提升点:1.可以全局关闭REDO(WL#13795),加速数据导入(用在例如做数据恢复或初始化期间)。2.

摘要:MySQL如期推出8.0.21版本,这里是 release notes。可能不少人在调侃MySQL为了ZZ正确,修改了诸如master/slave/whitelist/blacklist等专有名词,白做思想真是害死人。所幸这些改动在当前并没太大影响,旧的名词还能继续用一阵子。除此外,还有下面几个我认为也很重要的新功能或者性能提升点:1.可以全局关闭REDO(WL#13795),加速数据导入(用在例如做数据恢复或初始化期间)。2.2022年12月15日

MySQL 8.0.21来了,CREATE TABLE…SELECT可以使用了

MySQL 8.0.21来了,CREATE TABLE…SELECT可以使用了

摘要:MySQL如期推出8.0.21版本,这里是 release notes。可能不少人在调侃MySQL为了ZZ正确,修改了诸如master/slave/whitelist/blacklist等专有名词,白做思想真是害死人。所幸这些改动在当前并没太大影响,旧的名词还能继续用一阵子。除此外,还有下面几个我认为也很重要的新功能或者性能提升点:1.可以全局关闭REDO(WL#13795),加速数据导入(用在例如做数据恢复或初始化期间)。2.

摘要:MySQL如期推出8.0.21版本,这里是 release notes。可能不少人在调侃MySQL为了ZZ正确,修改了诸如master/slave/whitelist/blacklist等专有名词,白做思想真是害死人。所幸这些改动在当前并没太大影响,旧的名词还能继续用一阵子。除此外,还有下面几个我认为也很重要的新功能或者性能提升点:1.可以全局关闭REDO(WL#13795),加速数据导入(用在例如做数据恢复或初始化期间)。2.分类:DataBase

2022年11月30日

MySQL生产环境的高危操作

MySQL生产环境的高危操作

摘要: 实际工作中,经常遇到一些临时应急需求,DBA没有充分准备之前,直接到线上执行一些命令,除此之外一些没有考虑清楚厉害关系的命令,最后导致事故的情况。MySQL DBA运维中那些动作属于危险性操作?MySQL数据库操作:1. shutdown/restart命令(8.0版本): 关闭 mysql服务,重新启动,平时在运行习惯,在测试环境随意执行,到生产无意识执行这些命令。大事务运行还没结束,执行

摘要: 实际工作中,经常遇到一些临时应急需求,DBA没有充分准备之前,直接到线上执行一些命令,除此之外一些没有考虑清楚厉害关系的命令,最后导致事故的情况。MySQL DBA运维中那些动作属于危险性操作?MySQL数据库操作:1. shutdown/restart命令(8.0版本): 关闭 mysql服务,重新启动,平时在运行习惯,在测试环境随意执行,到生产无意识执行这些命令。大事务运行还没结束,执行分类:DataBase

2022年11月28日

PostgreSQL查看表空间和表占用空间大小

PostgreSQL查看表空间和表占用空间大小

摘要:1.查看所有表所占磁盘空间大小select sum(t.size) from (SELECT table_schema || '.' || table_name AS table_full_name, pg_total_relation_size('"' || table_schema || '"."' || table_name || '"')AS sizeFROM information_schema.tablesORDER BYpg_total_relation_size('"' || table_schema || '"."' || table_name || '"') DESC

分类:DataBase

2022年11月23日

MySQL8.0新增系统参数清单

MySQL8.0新增系统参数清单

摘要:activate_all_roles_on_login此参数在版本8.0.2引入,是一个可以动态调整的global级参数,默认值为OFF。此参数用于控制在账户登录时是否激活已经授予的角色,如果为ON则授予的角色会被激活,设置为OFF时只能通过SET DEFAULT ROLE显式激活用户角色。activate_all_roles_on_login设置只在账户登录或者开始执行存储过程时生效,如果想更改session的role需要执行SET ROLE语句。binl

摘要:activate_all_roles_on_login此参数在版本8.0.2引入,是一个可以动态调整的global级参数,默认值为OFF。此参数用于控制在账户登录时是否激活已经授予的角色,如果为ON则授予的角色会被激活,设置为OFF时只能通过SET DEFAULT ROLE显式激活用户角色。activate_all_roles_on_login设置只在账户登录或者开始执行存储过程时生效,如果想更改session的role需要执行SET ROLE语句。binl分类:DataBase

2022年11月23日

从业三年的DBA总结的SQL优化经验

从业三年的DBA总结的SQL优化经验

摘要:SQL优化是数据库优化的一部分,数据库优化又是系统优化的一部分。本篇着重讲解SQL优化的一些技巧,另外,硬件基础、业务类型、存储结构也是影响SQL执行效率的重要因素,是SQL优化的前置条件。一、SQL优化的前置条件1、硬件基础数据库是操作系统之上的一种数据管理软件,其SQL最终的执行还是需要在硬件层面执行,所以硬件条件如CPU核数、内存大小、磁盘转速、网络带宽等是保障数

摘要:SQL优化是数据库优化的一部分,数据库优化又是系统优化的一部分。本篇着重讲解SQL优化的一些技巧,另外,硬件基础、业务类型、存储结构也是影响SQL执行效率的重要因素,是SQL优化的前置条件。一、SQL优化的前置条件1、硬件基础数据库是操作系统之上的一种数据管理软件,其SQL最终的执行还是需要在硬件层面执行,所以硬件条件如CPU核数、内存大小、磁盘转速、网络带宽等是保障数分类:DataBase

2022年10月26日

MySQL使用全文索引替换 like '%XX%' 查询

MySQL使用全文索引替换 like '%XX%' 查询

摘要:其实全文检索在MySQL里面很早就支持了,只不过一直以来只支持英文。缘由是他从来都使用空格来作为分词的分隔符,而对于中文来讲,显然用空格就不合适,需要针对中文语义进行分词。这不,从MySQL 5.7.6开始,MySQL内置了ngram全文检索插件,用来支持中文分词,并且对MyISAM和InnoDB引擎有效。低版本可以使用MySQL中文分词插件SqlJieba/mysqlcft等注意: &nb

摘要:其实全文检索在MySQL里面很早就支持了,只不过一直以来只支持英文。缘由是他从来都使用空格来作为分词的分隔符,而对于中文来讲,显然用空格就不合适,需要针对中文语义进行分词。这不,从MySQL 5.7.6开始,MySQL内置了ngram全文检索插件,用来支持中文分词,并且对MyISAM和InnoDB引擎有效。低版本可以使用MySQL中文分词插件SqlJieba/mysqlcft等注意: &nb分类:DataBase

2022年10月25日

使用canal-adapter-1.1.5时时增量同步数据从MySQL到MySQL

使用canal-adapter-1.1.5时时增量同步数据从MySQL到MySQL

摘要:原理:一、使用JDBC方式同步1. 使用Canal组件完成binlog的解析和数据同步;2. Canal-Server进程会伪装成MySQL的slave,使用MySQL的binlog同步协议完成数据同步;3. Canal-Adapter进程负责从canal-server获取解析后的binlog,并且通过jdbc接口写入到MySQL中;主机拓扑图:ip:172.16.1.222 canal-admin canal-server canal-adapter&

摘要:原理:一、使用JDBC方式同步1. 使用Canal组件完成binlog的解析和数据同步;2. Canal-Server进程会伪装成MySQL的slave,使用MySQL的binlog同步协议完成数据同步;3. Canal-Adapter进程负责从canal-server获取解析后的binlog,并且通过jdbc接口写入到MySQL中;主机拓扑图:ip:172.16.1.222 canal-admin canal-server canal-adapter&分类:系统管理

2022年10月23日

PostgreSQL-10.22编译安装

PostgreSQL-10.22编译安装

摘要:所有的源码包地址:https://ftp.postgresql.org/pub/source/安装源码包之前,需要先准备好编译环境和安装必要的包:yum groupinstall "Development tools"yum install -y bison flex readline-devel zlib-devel make gmake epel-release lsof screen lrzsz nmap 下载完后,上传到服务器上一、添加用户groupadd postgresuseradd -g postgres postgrespasswd 1234

摘要:所有的源码包地址:https://ftp.postgresql.org/pub/source/安装源码包之前,需要先准备好编译环境和安装必要的包:yum groupinstall "Development tools"yum install -y bison flex readline-devel zlib-devel make gmake epel-release lsof screen lrzsz nmap 下载完后,上传到服务器上一、添加用户groupadd postgresuseradd -g postgres postgrespasswd 1234分类:DataBase

2022年10月12日

SQL优化案例-通过添加主表的条件来影响优化器的行为

SQL优化案例-通过添加主表的条件来影响优化器的行为

摘要:SQL语句:SELECT pai.*, pa.apply_no, pa.apply_type, pa.create_by, pa.`status` AS applyStatus, pa.applier_user_code, pa.apply_name, pa.business_type, pa.store_id, pa.store_name, erp_spec_id, erp_product_id, CASE pa.STATUS WHEN 8 THEN 0 WHEN 1

摘要:SQL语句:SELECT pai.*, pa.apply_no, pa.apply_type, pa.create_by, pa.`status` AS applyStatus, pa.applier_user_code, pa.apply_name, pa.business_type, pa.store_id, pa.store_name, erp_spec_id, erp_product_id, CASE pa.STATUS WHEN 8 THEN 0 WHEN 1分类:DataBase

2022年09月20日

Flink-1.13.2 Standalone 集群安装配置

Flink-1.13.2 Standalone 集群安装配置

摘要:介绍 Flink提供了多种部署方式,本文介绍standalone 三节点模式,这个是模式不依赖其它第三方工具,配置简单Stanalone CLuster 是一种独立的集群模式,集群运行不需要依赖外部系统,完全自己独立进行管理。三台机器部署情况: 1、解压安装包tar -zxvf flink-1.13.2-bin-scala_2.11.tgz在每台主机上配置主机名(注意:一定要配置主机名,主机名不能是localhost)hostnam

摘要:介绍 Flink提供了多种部署方式,本文介绍standalone 三节点模式,这个是模式不依赖其它第三方工具,配置简单Stanalone CLuster 是一种独立的集群模式,集群运行不需要依赖外部系统,完全自己独立进行管理。三台机器部署情况: 1、解压安装包tar -zxvf flink-1.13.2-bin-scala_2.11.tgz在每台主机上配置主机名(注意:一定要配置主机名,主机名不能是localhost)hostnam分类:系统管理

2022年08月23日

mysql-to-clickhouse flink字段类型对应表

mysql-to-clickhouse flink字段类型对应表

摘要: mysql clickhosue flink`id` INT(10) UNSIGNED NOT NULL AUTO_INCREMENT

分类:DataBase

2022年08月20日

Flink-SQL网页管理工具-flink-streaming-platform-web配置

Flink-SQL网页管理工具-flink-streaming-platform-web配置

摘要:1.简介flink-streaming-platform-web系统是基于Apache Flink 封装的一个可视化的、轻量级的flink web客户端系统,用户只需在web 界面进行sql配置就能完成流计算任务。主要功能:包含任务配置、启/停任务、告警、日志等功能,支持sql语法提示,格式化、sql语句校验。目的:减少开发、降低成本 完全实现sql化 流计算任务。 1、主要功能[1] 任务支持单流 、双流、 单流与

摘要:1.简介flink-streaming-platform-web系统是基于Apache Flink 封装的一个可视化的、轻量级的flink web客户端系统,用户只需在web 界面进行sql配置就能完成流计算任务。主要功能:包含任务配置、启/停任务、告警、日志等功能,支持sql语法提示,格式化、sql语句校验。目的:减少开发、降低成本 完全实现sql化 流计算任务。 1、主要功能[1] 任务支持单流 、双流、 单流与分类:DataBase

2022年08月16日

flink-connector-clickhouse编译安装配置

flink-connector-clickhouse编译安装配置

摘要:官方链接:https://github.com/itinycheng/flink-connector-clickhouse编译的前题是要安装好jdk和mvn,这里省略Flink ClickHouse ConnectorFlink SQL connector for ClickHouse database, this project Powered by ClickHouse JDBC.Currently, the project supports Source/Sink Table and Flink Catalog.Please create issues if you encounter bugs and any help for the proj

分类:DataBase

2022年08月16日

通过Flink SQL基于binlog将MySQL数据时时同步到另一个库中

通过Flink SQL基于binlog将MySQL数据时时同步到另一个库中

摘要:环境配置:CentOS:[root@node212 ~]# cat /etc/redhat-releaseCentOS Linux release 7.6.1810 (Core)[root@node212 ~]# uname -aLinux node212 4.4.219-1.el7.elrepo.x86_64 #1 SMP Sun Apr 12 16:13:06 EDT 2020 x86_64 x86_64 x86_64 GNU/Linux[root@node212 ~]#flink-1.13.2(这个版本不需要编译,直接解压就可以使用) flink-1.13.2-bin-scala_2.

摘要:环境配置:CentOS:[root@node212 ~]# cat /etc/redhat-releaseCentOS Linux release 7.6.1810 (Core)[root@node212 ~]# uname -aLinux node212 4.4.219-1.el7.elrepo.x86_64 #1 SMP Sun Apr 12 16:13:06 EDT 2020 x86_64 x86_64 x86_64 GNU/Linux[root@node212 ~]#flink-1.13.2(这个版本不需要编译,直接解压就可以使用) flink-1.13.2-bin-scala_2.分类:DataBase

2022年06月19日

从零开始配置MySQL8.0.25 InnoDB Cluster高可用集群

从零开始配置MySQL8.0.25 InnoDB Cluster高可用集群

摘要:架构图:服务规划服务器 IP 端口 角色node11 172.16.1.11 6446 master shell routernode12 172.16.1.12 &nb

摘要:架构图:服务规划服务器 IP 端口 角色node11 172.16.1.11 6446 master shell routernode12 172.16.1.12 &nb分类:DataBase

2022年06月18日

MySQL[5.7-8.0] proxy user代理用户配置详解

MySQL[5.7-8.0] proxy user代理用户配置详解

摘要:其实MySQL版本发展到8.0,已经完全没有必要使用 proxy 用户这个功能了,可以用角色完美替代。auth_test_plugin.so 是 MySQL 5.5 的插件,仅限于测试环境,不推荐线上使用,仅限功能演示。之后的一系列大版本安装包里都不包含这个插件,所以使用方法有些差异。下面我对 proxy 用户在 MySQL 8.0 下如何使用做下简单演示,此方法也同样适合MySQL 5.7的版本。我在下面示例中使用插件

摘要:其实MySQL版本发展到8.0,已经完全没有必要使用 proxy 用户这个功能了,可以用角色完美替代。auth_test_plugin.so 是 MySQL 5.5 的插件,仅限于测试环境,不推荐线上使用,仅限功能演示。之后的一系列大版本安装包里都不包含这个插件,所以使用方法有些差异。下面我对 proxy 用户在 MySQL 8.0 下如何使用做下简单演示,此方法也同样适合MySQL 5.7的版本。我在下面示例中使用插件分类:DataBase

2022年06月16日

详细告诉你MySQL数据库的数据扫描方法

详细告诉你MySQL数据库的数据扫描方法

摘要:引言关于存储引擎的介绍有很多,基于HEAP的传统存储引擎,以及基于聚簇索引的Innodb引擎等,但优化器如何充分利用存储引擎的特点来实现快速高效的扫描,从而以最小的代价得到用户所需要的结果,是一个非常复杂过程。为了了解优化器是如何运作的,首先我们要了解每一种扫描方式的特点,下面我们以MySQL为例,就一些常见的表扫描方式进行讨论。全表扫描MySQL的full table scan本质

摘要:引言关于存储引擎的介绍有很多,基于HEAP的传统存储引擎,以及基于聚簇索引的Innodb引擎等,但优化器如何充分利用存储引擎的特点来实现快速高效的扫描,从而以最小的代价得到用户所需要的结果,是一个非常复杂过程。为了了解优化器是如何运作的,首先我们要了解每一种扫描方式的特点,下面我们以MySQL为例,就一些常见的表扫描方式进行讨论。全表扫描MySQL的full table scan本质分类:DataBase

2022年05月29日

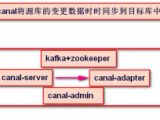

MySQL数据抽取CDC工具canal-1.1.5+kafka部署测试全记录

MySQL数据抽取CDC工具canal-1.1.5+kafka部署测试全记录

摘要:运行环境:操作系统: CentOS 7.9canal相关组件: zookeeper-3.4.14.tar.gz &nb

摘要:运行环境:操作系统: CentOS 7.9canal相关组件: zookeeper-3.4.14.tar.gz &nb分类:DataBase

2022年04月26日

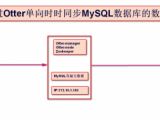

部署otter-4.2.18实现mysql主备数据时时同步

部署otter-4.2.18实现mysql主备数据时时同步

摘要:名称:otter ['ɒtə(r)]译意: 水獭,数据搬运工语言: 纯java开发定位: 基于数据库增量日志解析,准实时同步到本机房或异地机房的mysql/oracle数据库.工作原理一、环境准备 操作系统配置:关闭防火墙systemctl stop firewalld.servicesystemctl disable firewalld.service关闭SElinuxsed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/configset

摘要:名称:otter ['ɒtə(r)]译意: 水獭,数据搬运工语言: 纯java开发定位: 基于数据库增量日志解析,准实时同步到本机房或异地机房的mysql/oracle数据库.工作原理一、环境准备 操作系统配置:关闭防火墙systemctl stop firewalld.servicesystemctl disable firewalld.service关闭SElinuxsed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/configset分类:DataBase

2022年03月28日

Clickhouse同步mysql数据失败时,自动处理SHELL脚本

Clickhouse同步mysql数据失败时,自动处理SHELL脚本

摘要:Clickhouse通过物化引擎同步MySQL的数据,但如果Clickhouse遇到不能解析的EVENTS,则同步会失败,唯一的解决方法就是重新创建数据同步,但重新创建数据同步流程较多,以下这个脚本就是一个自动处理此类事件的,如下:填写需要监控的数据库名称:[root@node220 rsync_mysql_to_clickhouse]# pwd/server/shell_scripts/clickhouse/rsync_mysql_to_clickhouse[root@node220 rsync_

摘要:Clickhouse通过物化引擎同步MySQL的数据,但如果Clickhouse遇到不能解析的EVENTS,则同步会失败,唯一的解决方法就是重新创建数据同步,但重新创建数据同步流程较多,以下这个脚本就是一个自动处理此类事件的,如下:填写需要监控的数据库名称:[root@node220 rsync_mysql_to_clickhouse]# pwd/server/shell_scripts/clickhouse/rsync_mysql_to_clickhouse[root@node220 rsync_